吐司在线Lora模型训练参数设置含义简介

一:主要参数的含义:

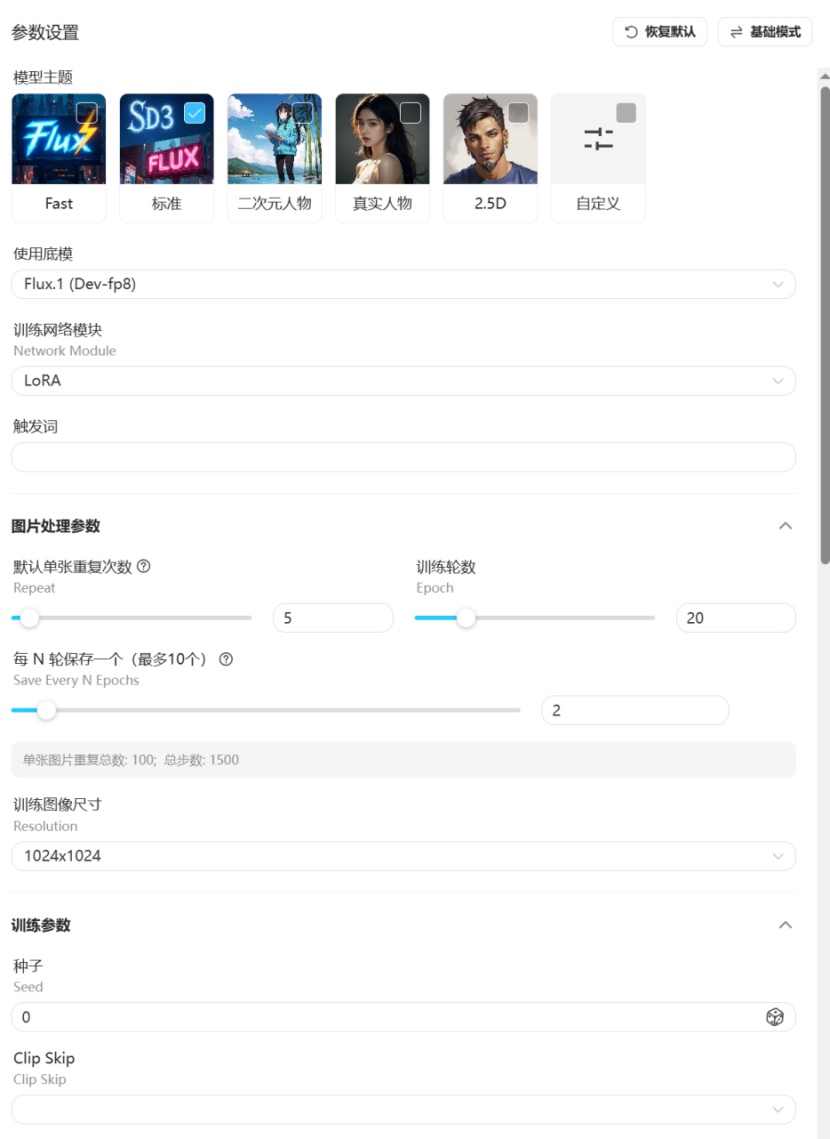

底膜:训练用的大模型

训练网络模块:包含lora,dora等

触发词:触发lora效果的提示词

单张重复次数(Repeat):训练一轮模型学习这张图片的次数,

训练轮数(Epoch):训练的总轮次,

总学习步数 = (图片数量 重复次数 epoch)/ 批次大小

以UNet学习率为1e-4为例,一般来说图片较少的时候训练人物需要至少1000步,训练画风则需要至少2500步,训练概念则需要至少3000步。这里只是最低的步数,图片多则需要更多步数。学习率更大可以适当减少步数,但并非线性关系,使用两倍的学习率需要使用比之前步数的一半更多的步数。

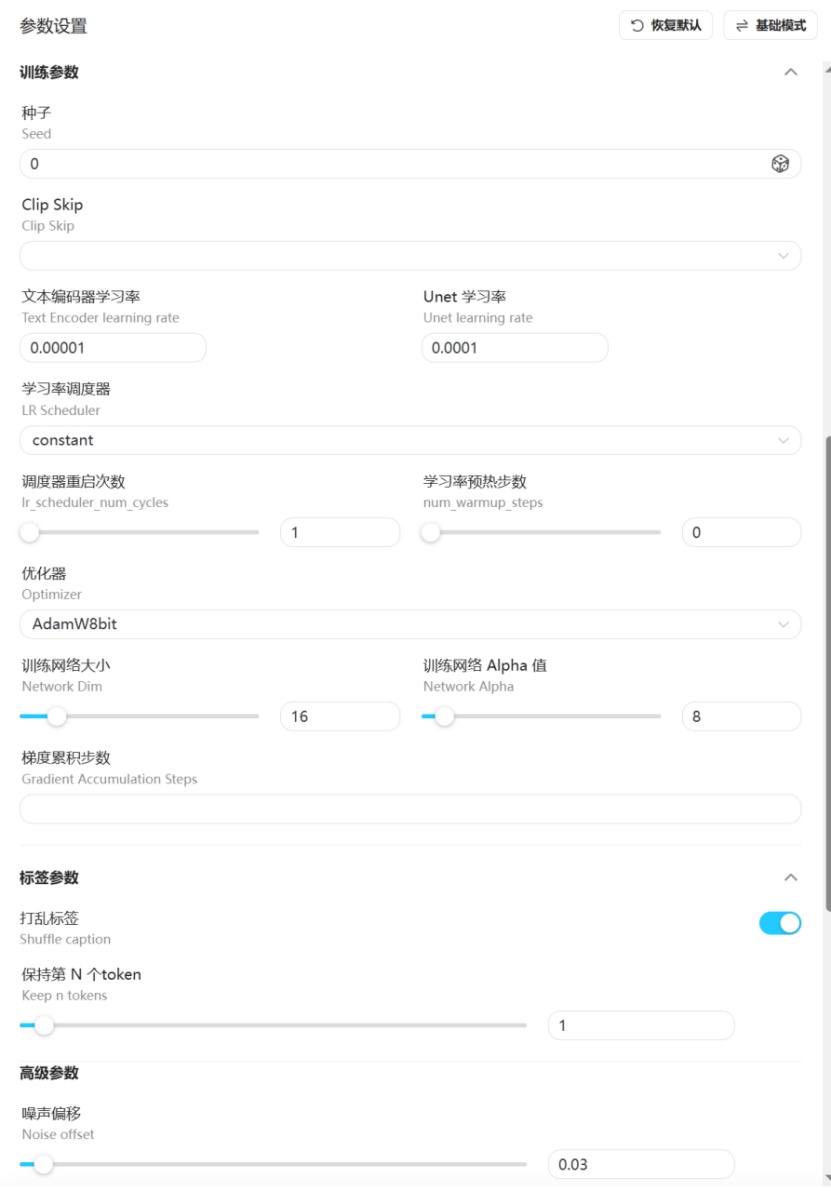

文本编码器学习率Text Encoder learning rate:

在训练过程中,用于更新文本编码器模型权重的参数。学习率是一个重要的超参数,它决定了模型在每次迭代中权重更新的幅度。

Unet 学习率Unet learning rate:

学习率决定了模型在每次迭代中参数更新的幅度,过大的学习率可能导致模型无法收敛,而过小的学习率则会导致训练过程缓慢且效果不佳。

训练图像尺寸:

训练集的分辨率大小

种子seed:

相当于图片的身份证

Clip skip:

是指在图像生成过程中控制CLIP模型使用频率的参数。CLIP模型是一种先进的神经网络,能够将输入的文本提示词转换为数值表示,并通过多层处理生成图像。Clip skip参数决定了在生成图像时CLIP模型处理的层数,从而影响图像的质量和与输入文本的匹配度。

学习率调度器:

是一种在训练过程中调整学习率的方法,通常会随着训练的进展而降低学习率。这有助于模型在训练开始时当参数远离其最佳值时进行大量更新。

优化器:

用于调整神经网络的权重和偏置,以最小化损失函数,从而提高模型的准确性和性能。优化器的目标是通过对模型参数的调整,逐步降低损失函数的值,确保每次优化都朝着最快降低损失的方向前进

训练网格大小

训练网格大小通常指的是在机器学习或深度学习中,用于模型训练的数据集的划分方式。具体来说,它将数据集划分为训练集、验证集和测试集。训练集用于训练模型,验证集用于调整模型参数,测试集用于评估模型的泛化能力。合理的网格大小划分可以帮助模型更好地学习和泛化,避免过拟合或欠拟合。

Alpha值:

Alpha值在机器学习中通常指的是学习率,它是一个超参数,用于控制模型在每次迭代中权重更新的步长。学习率的作用是平衡模型的训练速度和稳定性。一个合适的学习率可以帮助模型快速收敛到最优解,而过高或过低的学习率都可能导致训练效果不佳。通常,学习率被设置为一个较小的值,以便模型在训练过程中能够缓慢地探索和学习,避免出现不稳定的情况

噪声偏移:

在训练过程中加入全局的噪声,增加生成图像的动态范围(黑的更黑,白的更白)。

当不需要生成这类极亮或者极暗的图像时推荐关闭。

如果需要开启,推荐设置值为0.1,同时需要增加学习步数作为网络收敛更慢的补偿。

多分辨率噪声袁减率Multires noise discount和多分辨率噪声迭代次数Multires noise iterations:

多分辨率噪声减少(Multires Noise Discount)是一种算法,它通过迭代处理来减少图像噪声。这种方法通常用于图像的去噪过程。

多分辨率指的是从高分辨率开始处理,逐渐降低分辨率,直到达到某个停止条件。在每次迭代中,处理过程可能包括滤波、图像重建或其他噪声减少技术。

多分辨率噪声迭代次数(Multires Noise Iterations)则指的是在满足某些条件之前,需要执行多少次迭代。

卷积层维度conv dim和卷积层 Alpha 值conv alpha:

卷积层的维度(conv dim)是指卷积操作处理的数据的维度。在深度学习中,卷积层主要有三种类型:Conv1d、Conv2d和Conv3d,它们分别处理一维、二维和三维数据。

卷积层中的学习率调整或权重初始化相关的参数。

在卷积神经网络(CNN)中,卷积层是核心组成部分,主要用于特征提取。